여기서 Cost라는 것이 어떻게 생겨선지 보기 위해 matplotlib라이브러리로 확인해 볼 것이다.

X = [1, 2, 3]

Y = [1, 2, 3]

W = tf.placeholder(tf.float32)

# Our hypothesis for linear model X * W

hypothesis = X * W

# cost/loss function

cost = tf.reduce_mean(tf.square(hypothesis - Y))

X, Y의 값을 굉장히 간단한 데이터를 주고 w의 해당되는 것을 placeholder로주면서 값을 바꿔가면서 본다는 뜻이다.

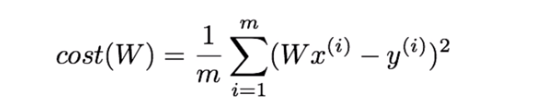

위 Cost를 tensor flow로 구현하면 tf.reduce_mean(tf.square(hypothesis - Y))가 된다.

sess = tf.Session()

sess.run(tf.global_variables_initializer())

W_history = []

cost_history = []

이제 세션을 열고 variable들을 초기화해준다. 그리고 그래프를 그리기 위해 w값과 Cost의 값들을 저장할 리스트를 만들어준다.

for i in range(-30, 50):

curr_W = i * 0.1

curr_cost = sess.run(cost, feed_dict={W: curr_W})

W_history.append(curr_W)

cost_history.append(curr_cost)

# Show the cost function

plt.plot(W_history, cost_history)

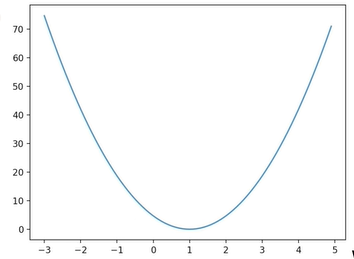

plt.show()그다음에 range를 -30부터 50까지 움직이면서 Cost와 w의 값을 확인해 본다. 그리고 matplotlib로 그래프를 그려본다.

그러면 아래 사진처럼 나오게 된다.

y축이 Cost이고 x축이 w이다. 여기에서 Cost가 밥그릇 모양으로 생겨 경사면을 따라내려 가기 아주 좋은 형태이다.

그림을 보면 알겠지만 최소화하는 값을 w가 1인 것이고 최솟값을 찾는 것이다. 미분을 활용하여 기울기를 구하는 것이다.

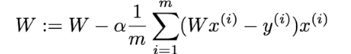

위식을 보면 기울기가 +일 때는 w가 -가 되고 기울기가 -일 때는 w가 +가된다. 이것을 tensorflow로 구현하면 아래 코드처럼 된다.

learning_rate = 0.1

gradient = tf.reduce_mean((w * X - Y) * X)

descent = w - learning_rate * gradient

update = w.assign(descent)위식의 알파를 learning_rate라고 하고 descent는 w에서 gradient를 뺀 것이 되고 assign을 하여 값이 바뀌게 된다. 위 코드가 바로 minimize 하는 과정이다. 하지만 미분하는 값이 어려워질 때 위 코드를 작성하는 게 힘들다. 그때 사용하는 코드가 바로 아래 코드이다.

train = tf.train.GradientDescentOptimizer(learning_rate=0.1).minimize(cost)tf.train.GradientDescentOptimizer를 선언하고 Cost를 minimize 하라고 하면 굳이 미분하지 않고도 tensor flow가 자동으로 구해준다. 이제 정말 되는지 확인하기 위해 아래 코드를 실행해본다.

# Lab 3 Minimizing Cost

import tensorflow as tf

# tf Graph Input

X = [1, 2, 3]

Y = [1, 2, 3]

# Set wrong model weights

W = tf.Variable(5.0)

# Linear model

hypothesis = X * W

# cost/loss function

cost = tf.reduce_mean(tf.square(hypothesis - Y))

# Minimize: Gradient Descent Optimizer

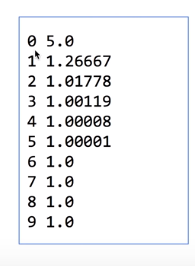

train = tf.train.GradientDescentOptimizer(learning_rate=0.1).minimize(cost)

# Launch the graph in a session.

with tf.Session() as sess:

# Initializes global variables in the graph.

sess.run(tf.global_variables_initializer())

for step in range(101):

_, W_val = sess.run([train, W])

print(step, W_val)

결과를 보면 처음에는 5.0이지만 학습을 거듭해갈수록 1.0으로 수렴해간다. GradientDescentOptimizer가 굉장히 잘되는 것을 확인할 수 있다.

공부한 사이트:https://www.youtube.com/watch?v=Y0EF9VqRuEA&list=PLlMkM4tgfjnLSOjrEJN31gZATbcj_MpUm&index=7

'머신러닝 > 모두를 위한 딥러닝' 카테고리의 다른 글

| multi-variable linear regression을 TensorFlow에서 구현하기 (0) | 2019.05.16 |

|---|---|

| multi-variable linear regression (0) | 2019.05.15 |

| Linear Regression의 cost 최소화 알고리즘의 원리 (0) | 2019.05.13 |

| TensorFlow로 간단한 linear regression을 구현 (0) | 2019.05.12 |

| Linear Regression의 Hypothesis 와 cost (0) | 2019.05.11 |